javascript

WS2812 5050 RGB

uni-app

完全背包

sklearn

产品经理培训

list

语言模型

图卷积神经网络

batch

wireshark

多任务学习

SpringBoot项目的创建

memory

量子计算

kylin

ruby

c++20

1+x web 例题

web前端大作业

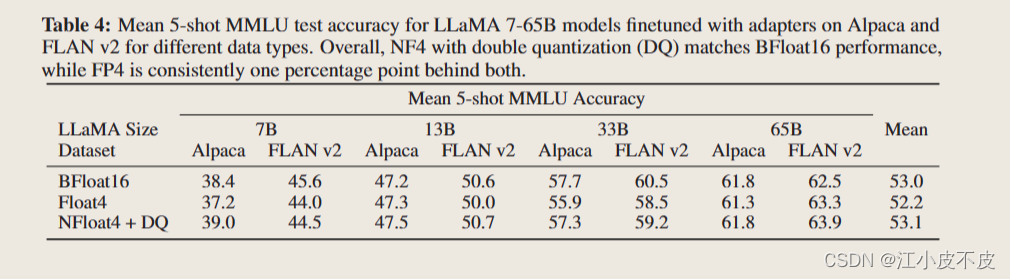

QLoRA

2024/4/13 11:11:10LIMA和QLoRA论文解读

《LIMA: Less Is More for Alignment》

paper: https://arxiv.org/abs/2305.11206 Meta在2023年5月发布了论文《LIMA: Less Is More for Alignment》,基于LLaMa-65B微调了大模型LIMA,号称只用了1000个精心策划的问题和答复进行微调,就达到了…

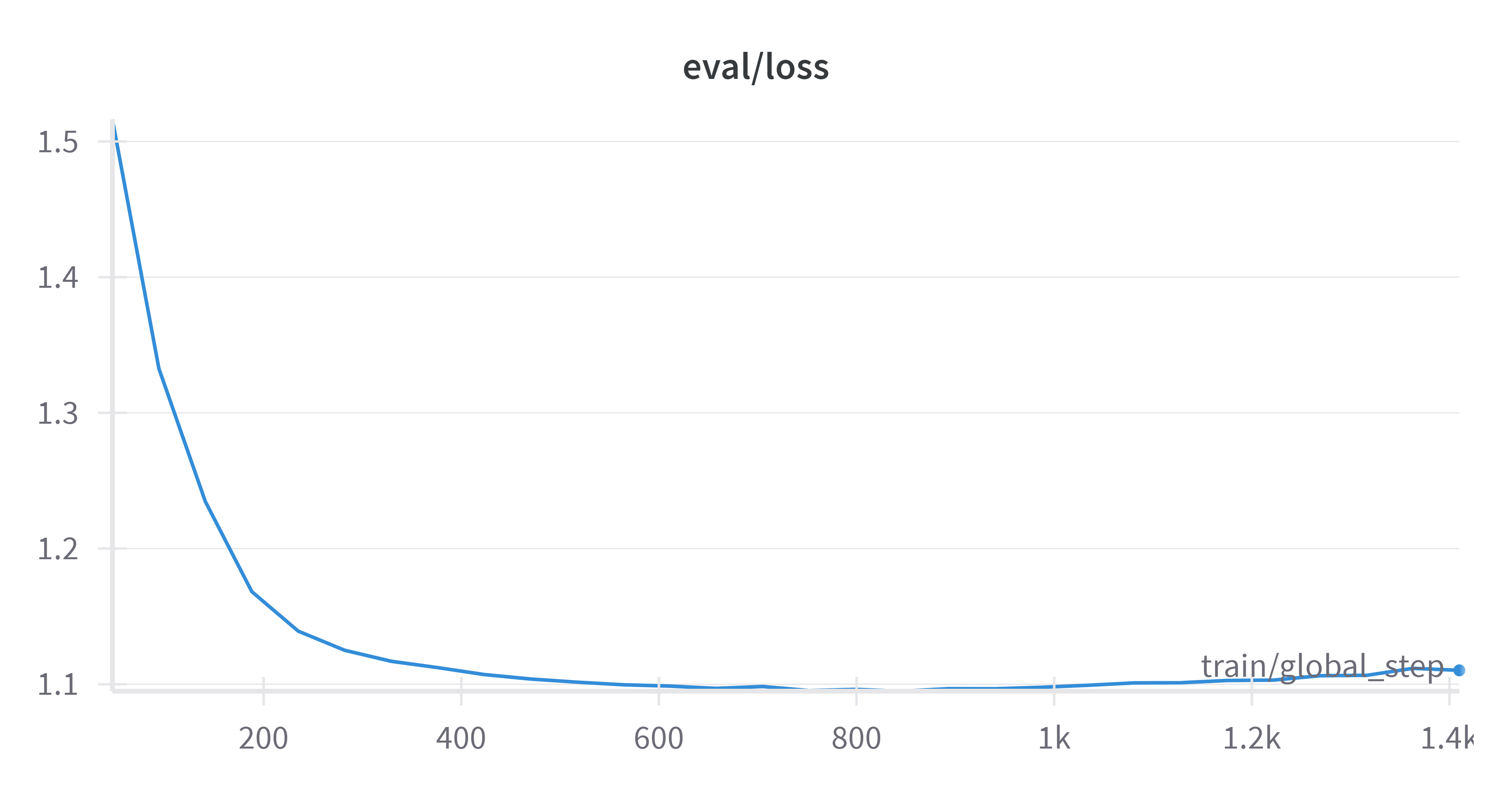

使用 QLoRA 在 Google Colab 中微调 Mistral 7b(完整指南)

使用 QLoRA 在 Google Colab 中微调 Mistral 7b(完整指南) 在本文中,我们将在一个名为 Enlighten 的游戏的整个代码库上微调 Mistral 7b,所有这些都在 Google Colab(或 Kaggle)中免费提供合成数据。在我们的…

Phi-2小语言模型QLoRA微调教程

前言

就在不久前,微软正式发布了一个 27 亿参数的语言模型——Phi-2。这是一种文本到文本的人工智能程序,具有出色的推理和语言理解能力。同时,微软研究院也在官方 X 平台上声称:“Phi-2 的性能优于其他现有的小型语言模型&#…

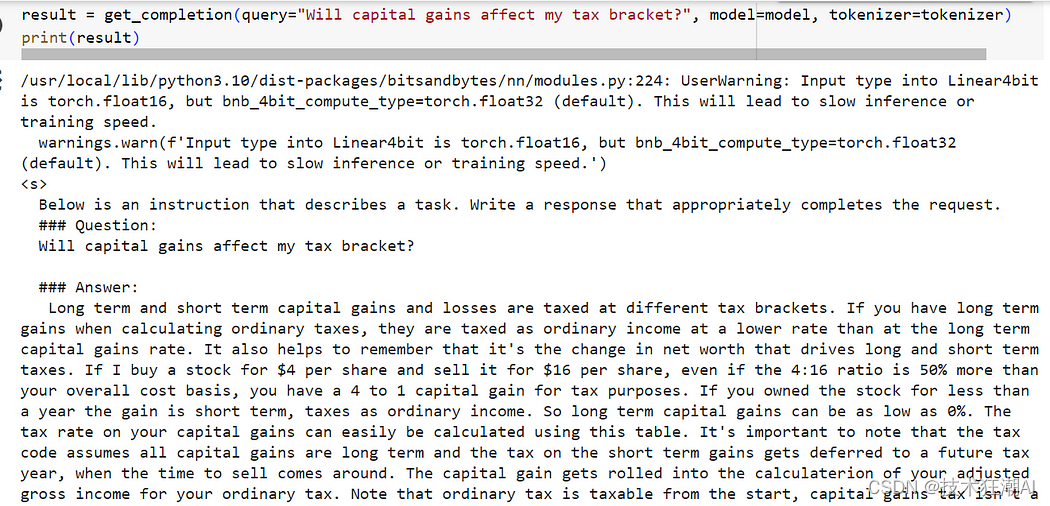

如何使用LoRA和PEFT微调 Mistral 7B 模型

一、前言

对于大模型在一些安全级别较高的领域,比如在金融服务领域实施人工智能解决方案时,面临的最大挑战之一是数据隐私、安全性和监管合规性。

因为担心数据泄露的问题,很多银行或机构都会回避利用人工智能的优势潜力,尤其是…